Hijacking

Dirottamento, inteso come dirottamento di una connessione o di una sessione. Con questo attacco un pirata è in grado intercettare i dati altrui, per esempio facendo ricorso all’ARP-poisoning. Si può parlare anche di Session Hijacking quando il Session ID (SID o token) di autenticazione viene intercettato, consentendo al pirata l’accesso ad una risorsa (per esempio un account di webmail) senza la necessità di conoscere la password.

Cybersecurity

Olimpiadi 2024: Wi-Fi pubblico poco sicuro

In occasione dei Giochi Olimpici e Paralimpici estivi, gli esperti di Kaspersky hanno analizzato circa 25.000 Wi-Fi pubblici a Parigi ed è emerso che quasi il 25% di queste reti ha una crittografia debole o assente

In vista delle Olimpiadi di Parigi, Kaspersky ha analizzato la sicurezza delle reti Wi-Fi aperte a cui i visitatori potrebbero collegarsi. Su 47.891 segnali analizzati in luoghi frequentati e sedi olimpiche (le aree di analisi comprendono: Arco di Trionfo, Avenue des Champs-Élysées, Museo del Louvre, Torre Eiffel, Cattedrale di Notre Dame, Senna, Trocadéro, Stadio di Francia), sono stati identificati 24.766 punti di accesso Wi-Fi unici. Un quarto di queste reti presenta gravi carenze di sicurezza, come crittografia debole o inesistente, rendendole vulnerabili agli attacchi. Inoltre, quasi il 20% delle reti usa WPS, un algoritmo obsoleto e facilmente compromettibile. Solo il 6% delle reti adotta il protocollo di sicurezza WPA3.

I criminali informatici potrebbero sfruttare queste reti per rubare dati sensibili degli utenti. Kaspersky consiglia di utilizzare una VPN, come Kaspersky VPN Secure Connection per criptare la connessione e proteggere i dati personali e finanziari su reti Wi-Fi pubbliche.

Per avere maggiori informazioni sulla sicurezza della rete Wi-Fi di Parigi, consigliamo di visitare il sito Kaspersky Daily

Quando si utilizza il Wi-Fi pubblico, gli esperti consigliano sempre di seguire alcune regole comportamentali:

- Evitare le transazioni sensibili: non accedere a conti bancari o ad altri servizi sensibili quando si utilizza il Wi-Fi pubblico.

- Verificare la rete: assicurarsi che sia legittima verificando con la struttura che la mette a disposizione.

- Attivare i firewall: controllare che il firewall del dispositivo sia attivo per bloccare gli accessi non autorizzati.

- Utilizzare password forti: impostare sempre password efficaci e uniche e attivare l’autenticazione a due fattori per una maggiore protezione.

- Aggiornare i software: eseguire regolarmente l’aggiornamento del sistema operativo, delle applicazioni e del software antivirus per proteggersi dalle minacce più recenti.

- Disattivare la condivisione dei file: per evitare accessi non autorizzati, disabilitare la condivisione di file e AirDrop sul dispositivo.

leggi anche: “Fan dei gliochi olimpici truffati”

*illustrazione articolo progettata da Freepik

Articoli

I gadget segreti degli hacker

La valigetta del pirata contiene dispositivi hi-tech piccoli, anonimi e potenti, facilmente acquistabili anche su Amazon. Ecco la nostra selezione

CASTELL DECO

BEN NASCOSTI SI’, MA IN UN VASO!

La cassaforte mimetizzata CASTELL DECO è un innovativo contenitore di sicurezza, camuffato da fioriera per uso interno ed esterno. Ideale per nascondere denaro, carte di credito e documenti, presenta un design intelligente. Realizzata con materiali robusti, include un contenitore in metallo con strato inferiore in acciaio e superiore in ABS, antiruggine e resistente alle intemperie. La serratura a chiave, con due chiavi incluse, garantisce sicurezza, mentre i fori preinstallati permettono un fissaggio stabile. Dimensioni compatte per una mimetizzazione discreta e efficace.

Quanto costa: € 26,97

Dove acquistarlo: su Amazon

EKNA

COSA SI CELA DIETRO IL TEMPO?

Si tratta di una cassaforte segreta, camuffata da orologio da parete, ideale per proteggere denaro, medicine, carte di credito, documenti, chiavi, gioielli e altri oggetti di valore. Realizzata con materiali robusti, offre una protezione indistruttibile e discreta. Il design autentico, con bevande e lattine originali dal mercato europeo, crea un’illusione perfetta per la protezione antifurto. Installabile come un normale orologio, si apre come una porta rivelando il vano segreto. La confezione include un orologio originale con scomparto nascosto, rendendolo anche un’idea regalo unica e funzionale.

Quanto costa: € 22,50

Dove acquistarlo: su Amazon

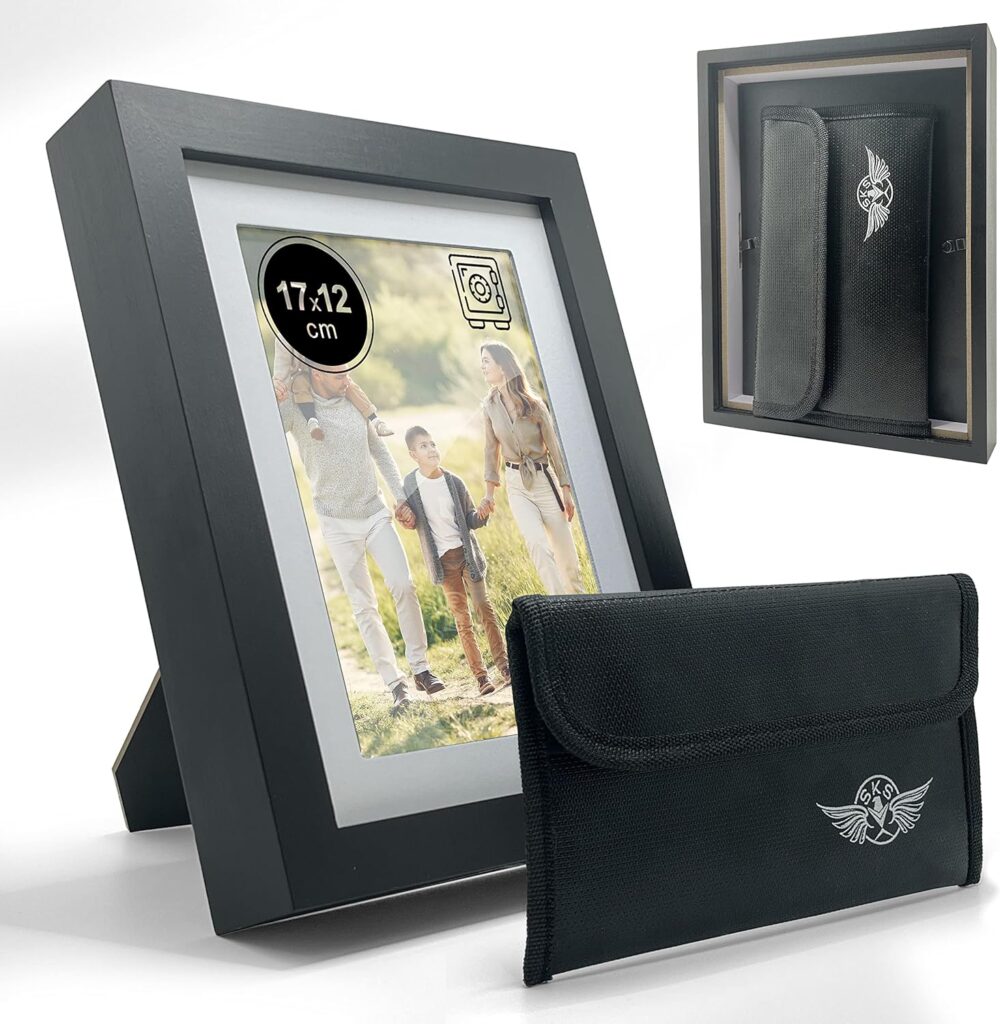

CORNICE PER FOTO

IN FOTO C’È MOLTO DI PIÙ

Questa cornice foto SKS rappresenta un avanzato nascondiglio segreto per denaro e oggetti di valore. Realizzata in legno di pino di alta qualità, garantisce robustezza e versatilità. La cornice, dotata di vetro liscio e resistente, include una borsa ignifuga e impermeabile, capace di proteggere i beni fino a 10 minuti di esposizione al fuoco diretto. Le dimensioni esterne sono 25 x 20 x 4,3 cm, mentre lo spazio interno misura 22 x 17 x 1,5 cm, perfetto per conservare documenti e gioielli. Utilizzabile come porta foto da tavolo o da parete, garantisce sicurezza discreta in piena vista

Quanto costa: € 24,00

Dove acquistarlo: su Amazon

Leggi anche: ” Scopri altri gadget segreti dell’hacker”

Articoli

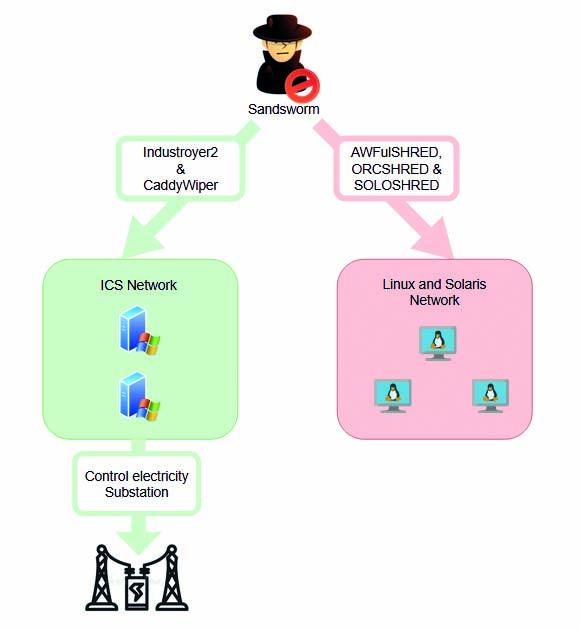

Energia sotto attacco hacker

Uno degli ultimi malware intercettati durante il cyberconflitto Russia-Ucraina ha colpito il settore energetico

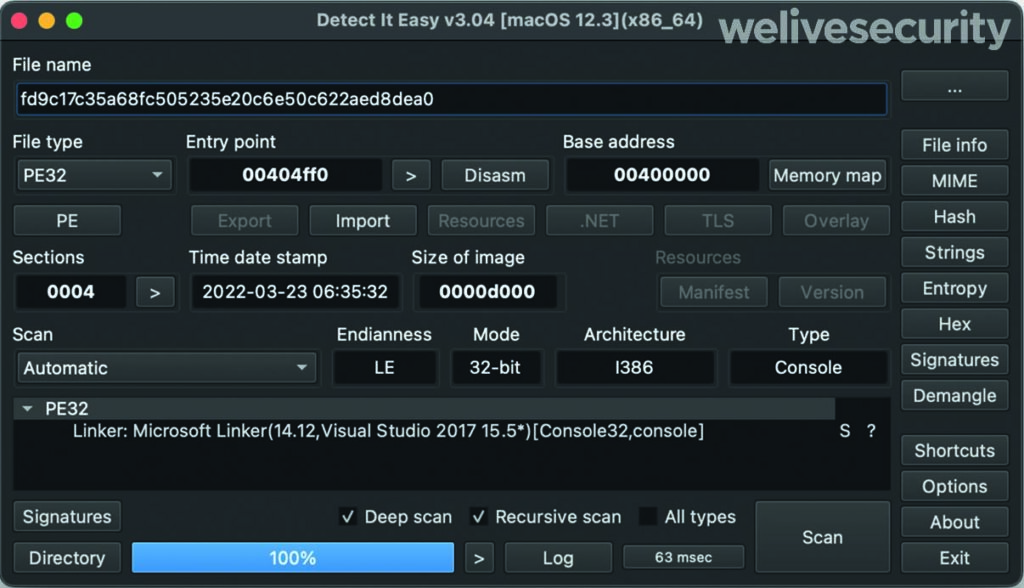

Di recente, il malware Industroyer2 si è distinto come una delle armi più pericolose impiegate nella guerra in Ucraina. Conosciuto anche come CrashOverride, si tratta di un agente altamente sofisticato che mira a compromettere i sistemi di automazione industriale (ICS), utilizzati ampiamente nel settore energetico. È in grado di infiltrarsi nei sistemi SCADA (Supervisory Control And Data Acquisition) e di compromettere le infrastrutture critiche, come le sottostazioni elettriche e le reti di distribuzione. Sfrutta vulnerabilità presenti nei protocolli di comunicazione utilizzati nei sistemi ICS, tra cui il protocollo IEC 61850, comunemente impiegato nel settore energetico. Attraverso l’analisi delle reti e l’intercettazione dei comandi di controllo, è in grado di eseguire attacchi mirati e causare il blackout delle reti elettriche.

Industroyer2 implementa solo il protocollo IEC-104 (noto anche come IEC 60870-5-104) per comunicare con le apparecchiature industriali. Fonte: https://www.welivesecurity.com

MODALITÀ DI ATTACCO

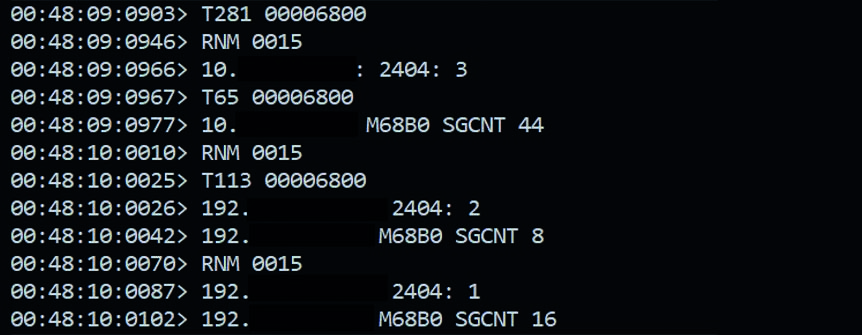

Industroyer2 si diffonde attraverso varie fasi di attacco, ognuna delle quali svolge un ruolo specifico nel compromettere l’infrastruttura target. Tra le sue funzionalità principali, possiamo identificare: il rilevamento della rete, l’analisi della rete e l’identificazione dei dispositivi, nonché l’individuazione di vulnerabilità presenti. Subito dopo, tenta di creare delle interferenze con i protocolli di comunicazione: il malware manipola i messaggi di controllo inviati tra le diverse componenti del sistema ICS. Ciò gli consente di assumere il controllo dei dispositivi e di modificare il loro comportamento. Infine, disabilita i dispositivi critici come interruttori, trasformatori e generatori, provocando un black-out e danni significativi alle infrastrutture.

Una volta avviato Industroyer2, si apre una finestra del prompt che visualizza i comandi che vengono inviati e ricevuti. In questo caso, a essere presa di mira è la porta 2404 utilizzata da IEC-104 per inviare messaggi TCP. Fonte: https://www.sentinelone.com

PAROLA D’ORDINE: COLLABORAZIONE

Durante gli attacchi ai sistemi energetici hanno causato black-out prolungati, con conseguente mancanza di elettricità per le comunità colpite. Questo ha avuto un impatto diretto sulle attività quotidiane, inclusi i servizi essenziali come l’approvvigionamento idrico, i trasporti e i servizi sanitari. Tanto che Industroyer2 ha spinto la comunità internazionale a intensificare gli sforzi per la prevenzione e la mitigazione delle minacce cibernetiche nel settore energetico. Le agenzie governative, i ricercatori di sicurezza informatica e le aziende del settore energetico stanno collaborando per sviluppare contromisure e soluzioni di difesa più efficaci.

NUOVA VERSIONE

In concomitanza con la diffusione di Industroyer2 nella rete ICS, gli attaccanti hanno distribuito anche una nuova versione del malware CaddyWiper, molto probabilmente con lo scopo di rallentare il processo di recupero e impedire agli operatori della compagnia energetica di riprendere il controllo delle console ICS. È stato anche distribuito sulla macchina in cui è stato eseguito Industroyer2, probabilmente per coprire le loro tracce.

Schema di funzionamento dell’attacco combinato di Industroyer2 e CaddyWiper. Fonte: https://www.headmind.com/fr/industroyer-2/

News

Guasto informatico a Microsoft

Dopo una giornata di disagi globali, l’azienda di sicurezza informatica CrowdStrike ha risolto il bug causato da un suo aggiornamento

L’Italia è stata colpita da una grave crisi informatica causata da un crash dei sistemi Windows, dovuto a un software di cybersecurity della Crowdstrike, azienda che produce la suite di sicurezza Falcon.

Il problema è stato causato da un file difettoso nella comunicazione tra l’agente Falcon e la piattaforma cloud, portando al blocco totale dei sistemi Windows, il cosiddetto Blue Screen of Death.

Ecco la soluzione temporanea suggerita da Crowdstrike: avviare Windows in modalità provvisoria, accedere alla cartella C:\Windows\System32\drivers\CrowdStrike ed eliminare il file difettoso C-00000291*.sys

Questo incidente ha avuto un impatto significativo su aziende europee e americane, con un calo del 20% nel valore delle azioni di Crowdstrike. Microsoft, sebbene inizialmente accusata, è risultata essere vittima del problema, che ha colpito duramente anche la sua infrastruttura cloud Azure. Il CEO di Crowdstrike ha rassicurato che i sistemi Mac e Linux non sono stati coinvolti. La risoluzione del problema sta procedendo rapidamente, ma il ripristino completo richiederà tempo dato il gran numero di server colpiti.

Articoli

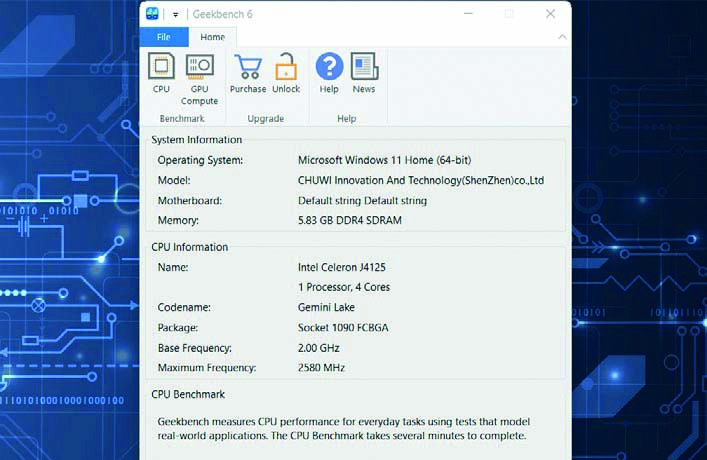

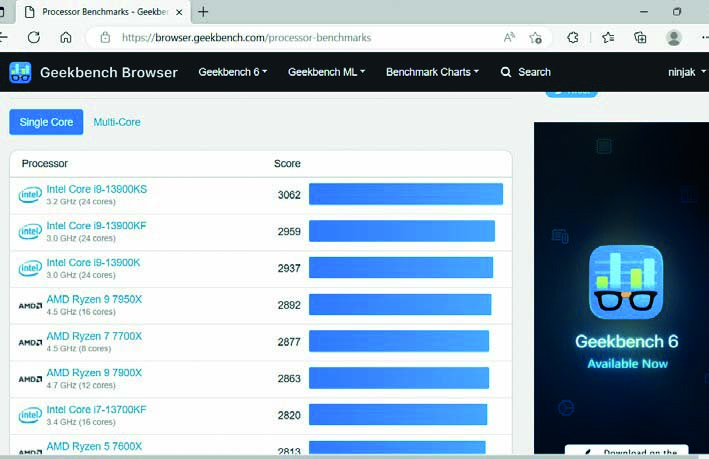

Misura le prestazioni del PC

I sistemi per monitorare le performance del sistema e sfruttare al massimo le sue potenzialità

Anni fa la prima cosa che faceva un appassionato di computer non appena cambiava una componente o acquistava un nuovo PC era far girare i cosiddetti benchmark, programmi creati per valutare le prestazioni di un computer. I più utilizzati erano i benchmark integrati all’interno dei motori di gioco (come Quake e Unreal), che servivano anche a capire se il computer fosse in grado di eseguire quello specifico titolo alla risoluzione scelta a una velocità accettabile.

PERCHÉ FARE UN TEST?

I programmi per effettuare benchmark sul computer fondamentalmente indicano la sua velocità tramite un numero. Più questo numero è elevato, maggiori sono le prestazioni. Questo valore, però, di per sé ha poco significato se non lo si paragona ad altre configurazioni, così da comprendere se la macchina è più veloce o più lenta di un’altra. Questo può tornarvi molto utile anche per capire l’impatto di una variazione nella configurazione del PC. Quanto cambia il valore se aumentate la RAM? E se sostituite il processore? Quanto è più veloce la nuova scheda grafica di quella precedente? I nuovi driver sono più efficienti o rallentano il PC rispetto a quelli precedenti? Questo programma gira meglio su CPU Intel o sui chip di Apple?

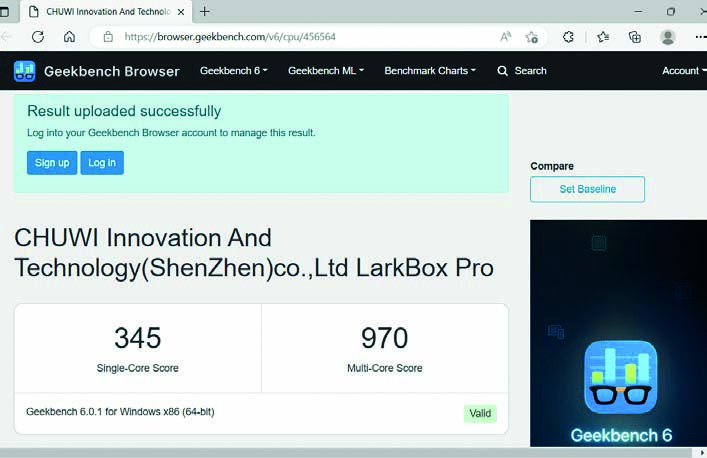

UNO DEI MIGLIORI

Tra i più noti, e meno complessi, programmi per la misurazione delle prestazioni dei computer (e non solo) troviamo Geekbench. Per dare un senso al punteggio, tenete conto del fatto che il software è calibrato attorno a un computer Dell Precision 3460 con processore Intel Core i7- 12700. Questa configurazione ottiene un punteggio base di 2.500. Geekbench effettua una serie di test. Il valore che vi interessa di più è quello Multi- Core, che misura le prestazioni dell’intero sistema. Il valore Single Core vi interessa relativamente, dato che la maggior parte delle applicazioni moderne sfrutta tutti i core presenti sul processore. Il test della GPU, invece, si limita a valutare le capacità di calcolo della scheda video, in ambito ludico e non solo. Potete scegliere fra due API: OpenCL e Vulkan. La prima è la più utilizzata in ambito Windows. Vulkan, invece, è meno diffusa ma sulla carta è in grado di offrire prestazioni migliori. A seguire eseguiamo entrambi i test.

DOWNLOAD

Collegatevi sul sito www.geekbench.com, cliccate su Download e scaricate la versione del programma per il vostro sistema operativo. Al termine del download fate doppio clic sul file .exe e procedete con l’installazione.

SERVE INTERNET

Avviate il programma: vi verrà presentata una schermata che riassume le caratteristiche del PC (processore, RAM e via dicendo). Chiudete tutti i programmi prima di eseguire il benchmark. Serve una connessione Internet attiva.

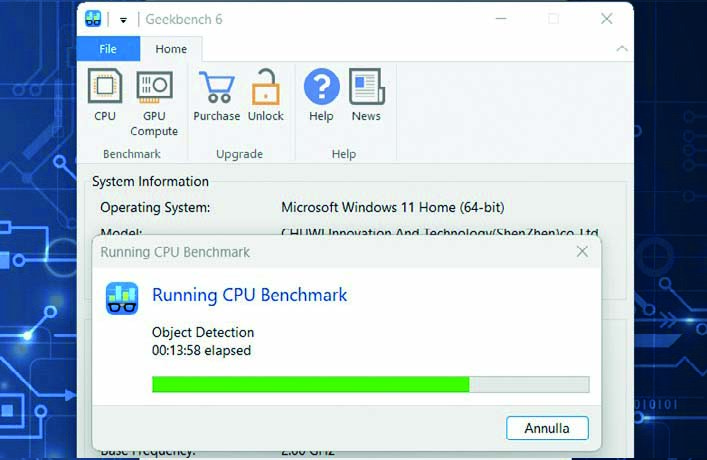

AVVIATE I TEST

Dopo aver chiuso tutte le applicazioni, potete cliccare su Run CPU Benchmark. Una volta fatto, prendetevi qualche minuto di pausa e non toccate il computer mentre vengono eseguiti i test.

REGISTRAZIONE?

Terminato il benchmark si aprirà una finestra del browser con il risultato numerico che indicherà le “prestazioni” del vostro PC. Se premete il pulsante Sign up potrete registrarvi sul sito di Geekbench e…

CONTROLLATE I VALORI

…salvare i vostri risultati online, confrontandoli con quelli di configurazioni simili, pubblicate da altri utenti. Se avete dei valori molto più bassi di un PC simile, valutate di aggiornare i driver, quantomeno.

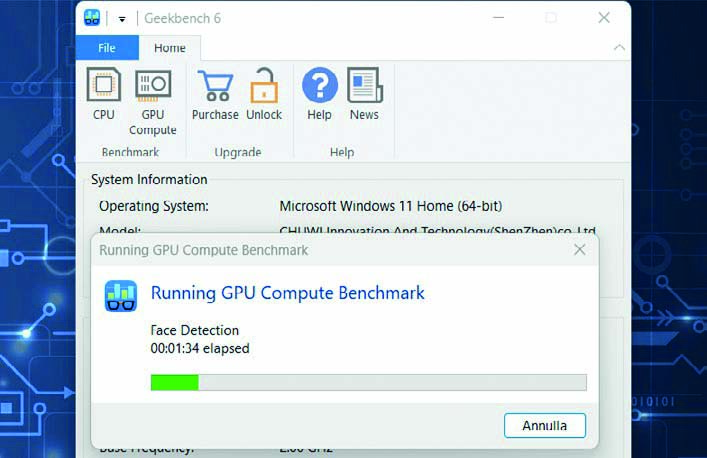

TESTATE LA POTENZA DELLA SCHEDA VIDEO

Tornate su Geekbench e premete in alto il pulsante GPU Compute per testare la potenza della scheda video. Al termine, ritroverete online anche questo valore, da confrontare con altre configurazioni simili.

Leggi anche: “Tracciamo l’attività del PC”

*illustrazione articolo progettata da Freepik

News

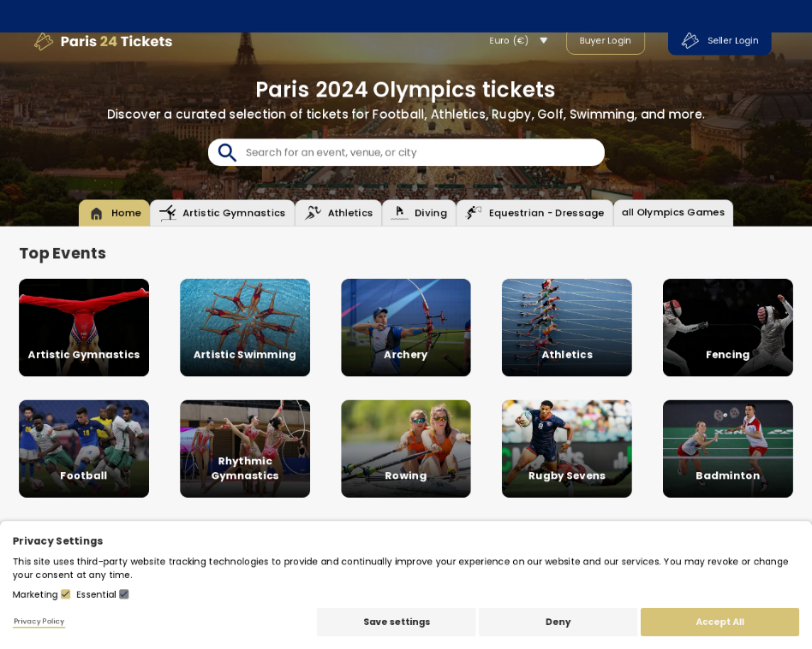

Fan dei Giochi Olimpici truffati

In vista delle prossime Olimpiadi Estive, che inizieranno il 26 luglio, si sono registrate una impennata delle attività di scamming legate all’evento, con truffatori che mirano a denaro e dati degli utenti. Kaspersky ha analizzato i siti Web di phishing legati alle Olimpiadi identificando i principali schemi attualmente in uso

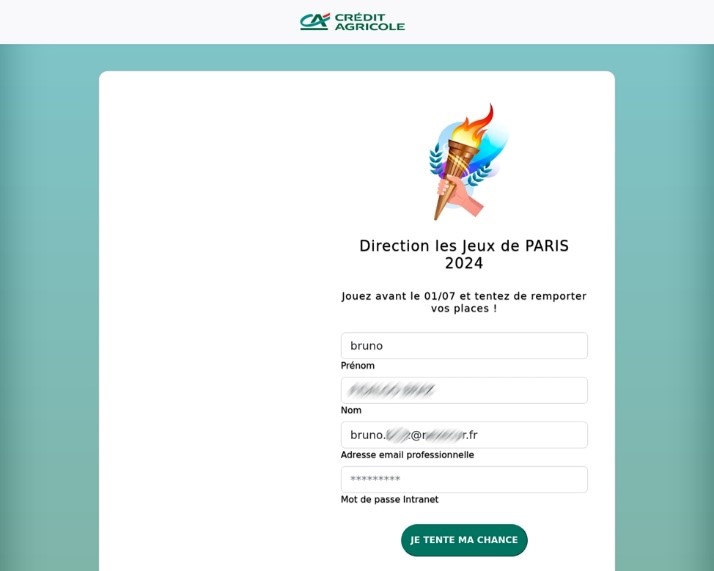

Gli esperti di Kaspersky hanno rilevato un aumento delle attività di scamming legate alle Olimpiadi di Parigi 2024. Dopo l’allarme del Comitato Olimpico sulle offerte di biglietti falsi e la truffa subita dalla famiglia di un nuotatore britannico, sono emersi numerosi siti Web di phishing. Questi siti offrono biglietti per eventi olimpici a prezzi vantaggiosi o per gare sold-out, ingannando gli utenti a fornire dati personali e denaro. Spesso le vittime non ricevono nulla o biglietti falsi, e i loro dati vengono venduti nel Dark Web. Inoltre, sono stati scoperti falsi premi aziendali che inducono i dipendenti a fornire credenziali di login, e store online fraudolenti che vendono articoli di merchandising senza mai consegnarli. Un’altra truffa comune è quella dei pacchetti dati gratuiti per telefoni mobili, che richiedono informazioni personali e dettagli di pagamento, utilizzati poi per scopi malevoli.

Un esempio di pagina di phishing che offre biglietti per le Olimpiadi

“Durante eventi importanti come le Olimpiadi, la quantità di offerte può essere enorme e molto rischiosa”, ha affermato Anton Yatsenko, Cybersecurity Expert di Kaspersky. “I truffatori sfruttano l’entusiasmo delle persone, per cui è fondamentale considerare ogni offerta con una sana dose di scetticismo. Bisogna ricordare che se una cosa sembra troppo bella per essere vera, probabilmente lo è. Prendetevi il tempo necessario per verificare l’autenticità delle offerte e proteggere i vostri dati personali. La vostra attenzione può fare la differenza tra godersi l’evento ed essere vittima di una truffa”.

Un esempio di pagina di phishing che propone biglietti per le Olimpiadi

Per evitare le truffe durante le Olimpiadi, gli esperti di Kaspersky hanno condiviso alcuni consigli:

- Verificare l’autenticità: acquistare biglietti, prodotti o servizi solo da fonti autorizzate e affidabili. Controllare il sito web ufficiale dell’evento per individuare i venditori abilitati.

- Essere scettici sulle offerte: se un’offerta sembra troppo bella per essere vera, è probabile che lo sia. Bisogna essere cauti nei confronti di sconti elevati e offerte esclusive, soprattutto se provengono da fonti sconosciute.

- Proteggere i propri dati: evitare di condividere informazioni personali e finanziarie su siti web sconosciuti. Assicurarsi che il sito sia sicuro verificando che sia presente “https” nell’URL e il simbolo del lucchetto nella barra del browser.

- Utilizzare software di sicurezza: aggiornare il software antivirus e di sicurezza per evitare malware e attacchi di phishing.

- Essere aggiornati: rimanere informati sulle tattiche di truffa più comuni e su come riconoscerle. Seguire gli ultimi aggiornamenti forniti da esperti di cybersecurity e da fonti ufficiali.

*illustrazione articolo progettata da Freepik

Corsi

Più competenze nella cybersecurity

Accordo tra Cyber Security Italy Foundation e ITS ICT Academy per promuovere professionalità nella comunicazione e sicurezza digitale

La comunicazione e la sicurezza digitale sono cruciali nella società moderna, facilitando lo scambio di informazioni e proteggendo dati sensibili. La Cyber Security Italy Foundation e la Fondazione ITS Information and Communications Technology Academy (ICT Academy) hanno firmato un protocollo d’intesa per promuovere competenze avanzate nella comunicazione e sicurezza digitale. Questo accordo mira a diffondere conoscenze di cybersecurity tra giovani e professionisti, attraverso scuole e centri per l’impiego, per colmare il gap di competenze in Italia.

Il presidente dell’ITS ICT Academy, Fabrizio Rizzitelli, ha sottolineato l’importanza della diffusione delle competenze digitali per creare una forza lavoro qualificata e aumentare la consapevolezza delle minacce informatiche. Marco Gabriele Proietti, presidente della Cyber Security Italy Foundation, ha parlato del “Progetto scuole” per l’educazione alla cybersecurity, che verrà esteso a livello nazionale.

ITS ICT Academy integra istruzione, formazione e lavoro, aggiornando professionisti e realizzando percorsi formativi. La Cyber Security Italy Foundation promuove l’innovazione tecnologica e supporta il trasferimento di know-how alle Pubbliche Amministrazioni e alle imprese. Entrambe le fondazioni mirano a sensibilizzare e diffondere una cultura della sicurezza digitale tramite ricerche, convegni, corsi e progetti innovativi.

Il protocollo d’intesa, della durata di un anno, prevede attività congiunte di divulgazione tecnica e scientifica, stage, orientamento e formazione, con l’obiettivo di sviluppare competenze professionali nel campo della comunicazione e della cybersecurity. Inoltre, le fondazioni promuoveranno la ricerca e l’innovazione tecnologica, sensibilizzando studenti e cittadini sull’importanza della sicurezza informatica e partecipando a bandi di concorso per progetti comuni.

Leggi anche: “Percorsi di formazione per accrescere le competenze digitali“

-

News3 anni ago

News3 anni agoHacker Journal 278

-

News7 anni ago

News7 anni agoAbbonati ad Hacker Journal!

-

Articoli2 anni ago

Articoli2 anni agoParrot Security OS: Linux all’italiana- La distro superblindata

-

Articoli3 anni ago

Articoli3 anni agoGuida: Come accedere al Dark Web in modo Anonimo

-

Articoli6 anni ago

Articoli6 anni agoSuperare i firewall

-

News4 anni ago

News4 anni agoLe migliori Hacker Girl di tutto il mondo

-

Articoli5 anni ago

Articoli5 anni agoCome Scoprire password Wi-Fi con il nuovo attacco su WPA / WPA2

-

News7 anni ago

News7 anni agoAccademia Hacker Journal